近日,软件学院在鲁棒机器学习研究方面取得新进展。刘晗副教授、黄星朔同学等人发现了现有算法中存在的边缘梯度差异问题和连续迭代梯度方向问题,通过融入数据依赖梯度先验和时间依赖梯度先验,大幅改善了基于决策的黑盒对抗攻击效果。研究成果《Boosting Decision-based Black-box Adversarial Attack with Gradient Priors》已被国际人工智能联合会议IJCAI2023(中国计算机学会认定的A类会议)录用,本届IJCAI大会投稿量达4566篇,录用率仅为15%。

机器学习模型已经在人脸支付、自动驾驶、语言识别等领域得到广泛应用,然而它们在面对对抗样本的攻击时十分脆弱。攻击者可以通过对模型的输入添加难以察觉的微小扰动,随意操纵模型的决策。研究对抗攻击有助于人们发现当前机器学习算法的局限性,并且可以为模型鲁棒性研究提供新的思路。

研究人员关注基于决策的黑盒图像对抗攻击问题,即攻击者通过对模型查询得到决策标签,来寻找对抗样本。在这一问题中,攻击者往往需要估计对抗损失关于输入图像的梯度,梯度估计的好坏直接决定着攻击的效果。现有方法在梯度估计过程中存在着边缘梯度差异问题和连续迭代梯度方向问题,使得攻击效果不佳。为此,研究人员提出了DBA-GP攻击框架,融合了精巧设计的数据依赖梯度先验和时间依赖梯度先验,有效解决了上述问题。

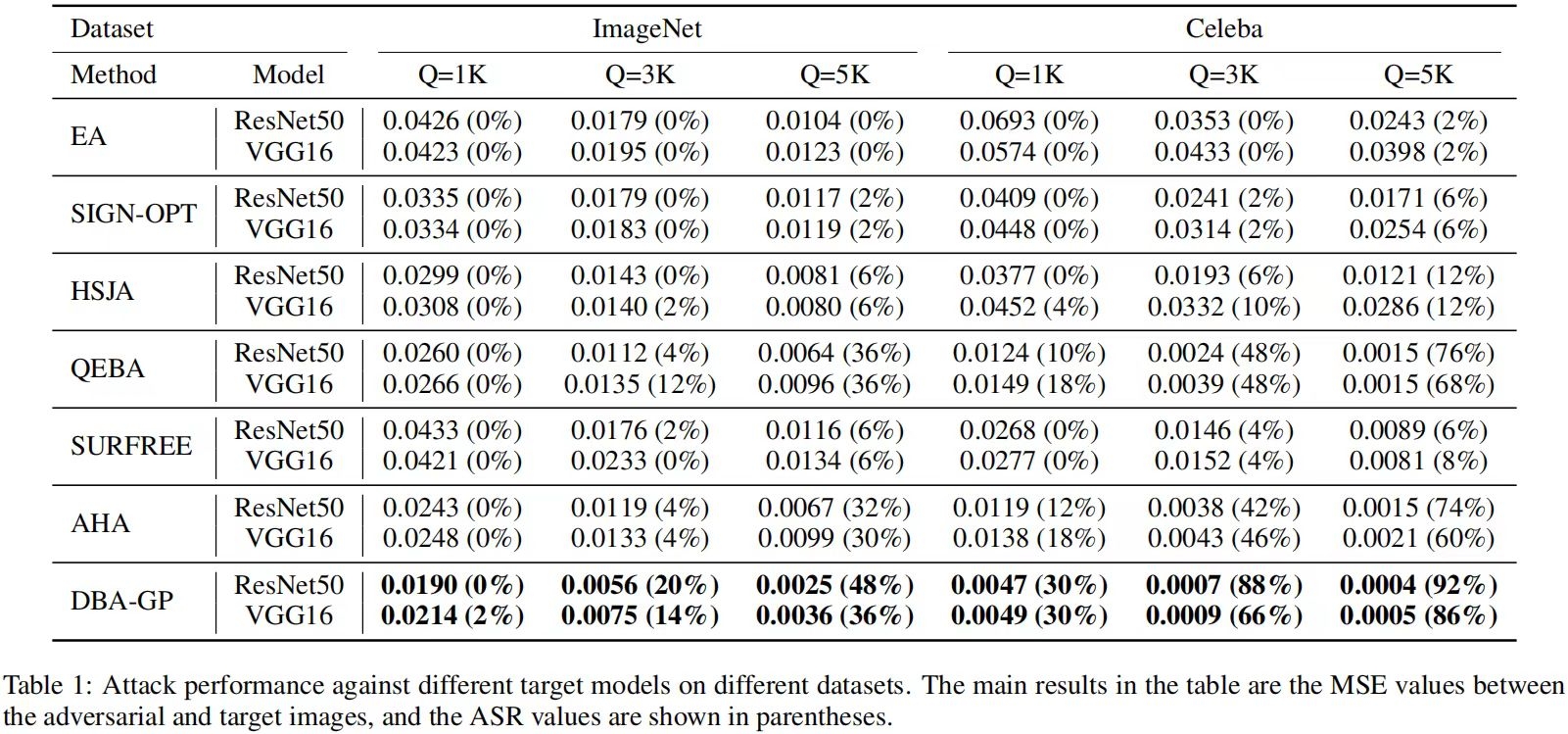

在针对ImageNet和Celeba上的公开模型的攻击实验表明,文章提出的DBA-GP方法在相同查询次数下,能产生最小的扰动并达到最高的攻击成功率,例如在攻击Celeba数据集上的ResNet50模型时,在3000次查询下攻击成功率由SOTA方法的48%提高至88%。

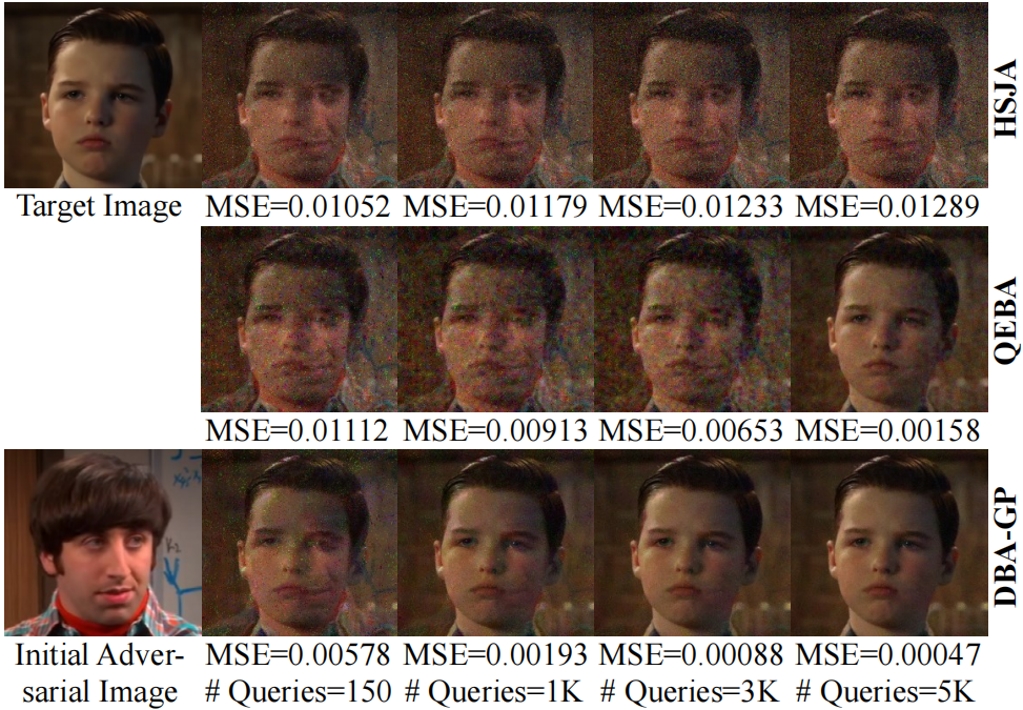

图1:对抗攻击结果展示

在针对旷视科技的Face++商用人脸比对API进行的攻击实验表明,DBA-GP大幅度优于现有的基线方法,在1000次查询内找到的对抗样本基本可以媲美其它方法5000次查询的攻击效果。这表明,DBA-GP在真实世界中有可能产生更大的威胁,已经成为考验模型对抗鲁棒性的强大基线。

图2:Face++攻击实验案例

该成果由软件学院刘晗副教授、黄星朔(2021级研究生)、张晓彤副教授、李其迈博士、马凤龙教授、王伟副教授、陈红阳研究员、于红副教授,张宪超教授共同完成。合作单位包括:香港理工大学、美国宾州州立大学、深圳北理莫斯科大学、之江实验室。

近年来,软件学院刘晗副教授所在研究团队专注于人工智能、机器学习领域的研究,取得的研究成果已得到国内外学者的广泛关注与积极评价。其中,在人工智能、机器学习领域已发表/录用中国计算机学会(CCF)A、B类等高水平国际期刊及会议30余篇,包括TKDE、KDD、AAAI、IJCAI、SIGIR、WWW、CVPR、ACL、EMNLP等。

会议背景:国际人工智能联合会议International Joint Conference on Artificial Intelligence(简称IJCAI)是人工智能领域顶级国际学术会议,是中国计算机学会(CCF)推荐的A类学术会议(A类指国际上极少数的顶级刊物和会议,鼓励我国学者去突破),在该领域具有极大的影响,代表人工智能领域的最高水平和发展方向。